如何下载和在本地使用Bert预训练模型 |

您所在的位置:网站首页 › GloVe中文 下载 › 如何下载和在本地使用Bert预训练模型 |

如何下载和在本地使用Bert预训练模型

|

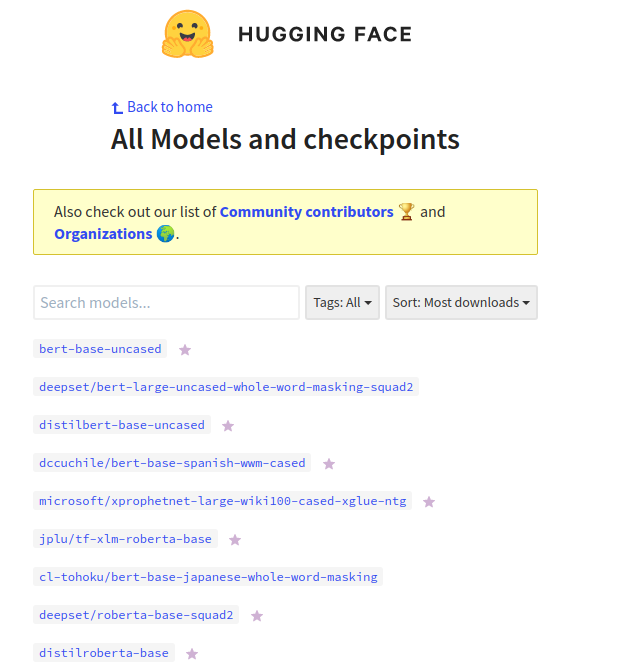

bert 预训练模型的下载有许多方式,比如从github官网上下载(官网下载的是tensorflow版本的),还可以从源码中找到下载链接,然后手动下载,最后还可以从huggingface中下载。 关于huggingface的介绍可以看这个:Huggingface简介及BERT代码浅析 从huggingface下载预训练模型的地址:https://huggingface.co/models 点进去是这样的:

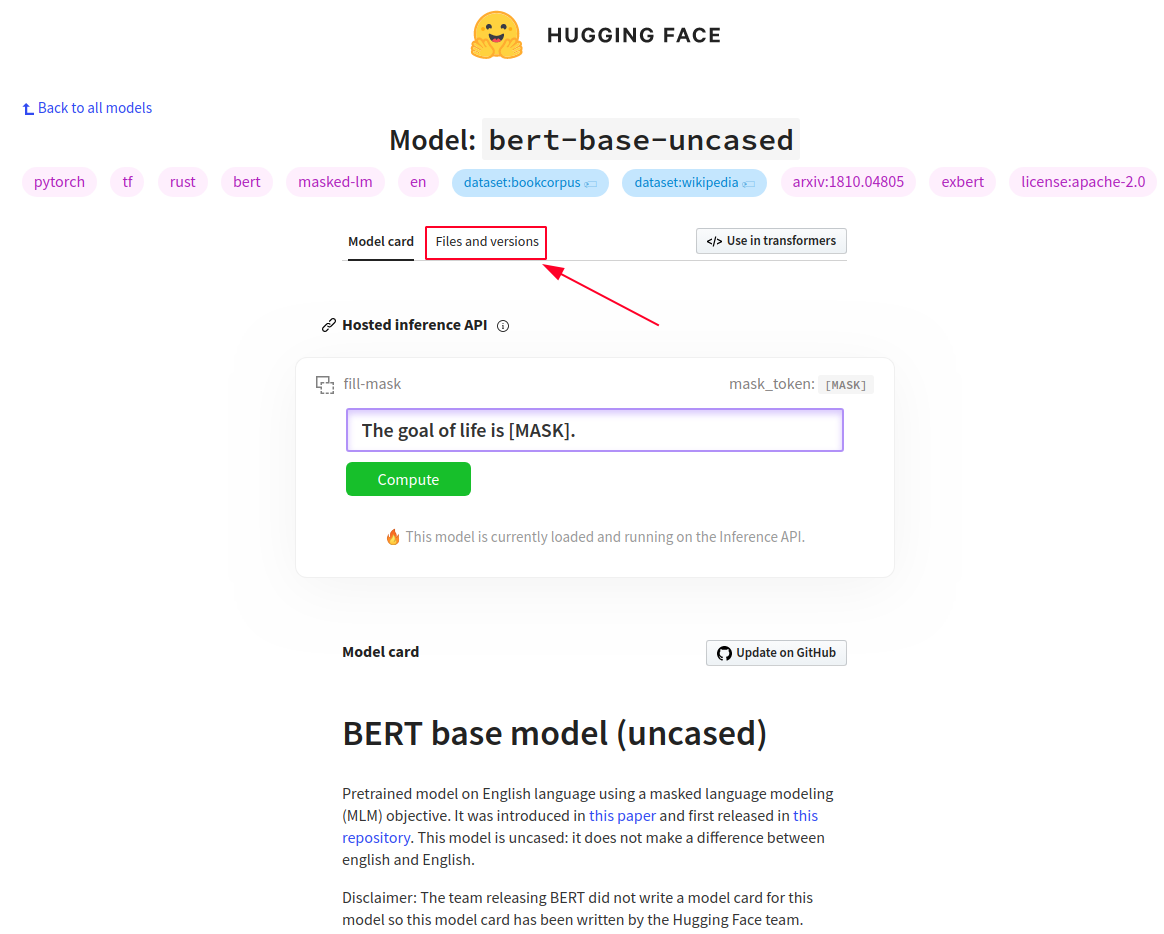

如果你想使用 bert-base-uncased 那么第一个就是,如果想使用别的预训练模型,还可以在搜索框中搜索。 以下载 bert-base-uncased 为例: 首先点击搜索框下面第一个链接,来到这个页面:

点击箭头所指位置,来到下载页面:

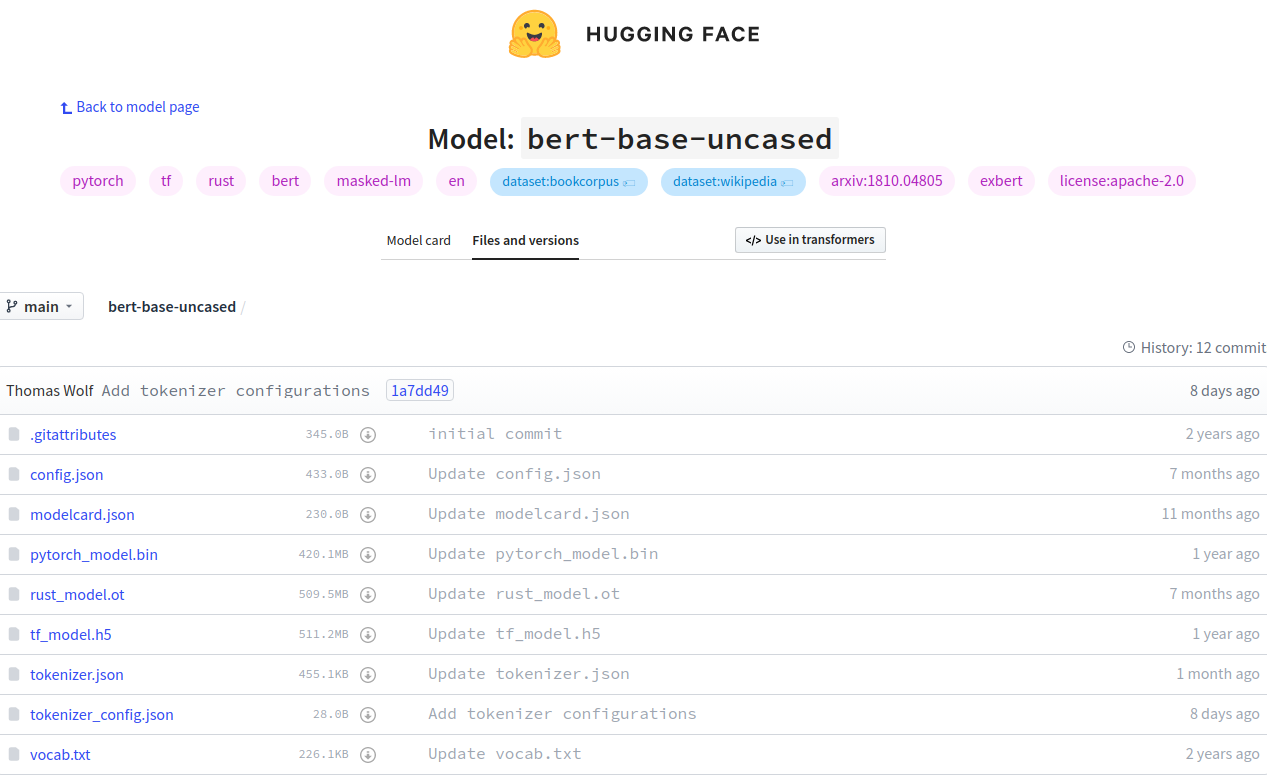

补充一张图:

有pytorch、tensorflow、rust三种语言的预训练模型,选择自己需要的下载即可,其他的还有配置文件,以及词库文件等等。 使用方法,以pytorch为例: 将下载好的文件放到一个目录里面,比如 bert-base-uncased ,然后用以下代码测试: from transformers import BertModel,BertTokenizer BERT_PATH = './bert-base-uncased' tokenizer = BertTokenizer.from_pretrained(BERT_PATH) print(tokenizer.tokenize('I have a good time, thank you.')) bert = BertModel.from_pretrained(BERT_PATH) print('load bert model over')输出: ['i', 'have', 'a', 'good', 'time', ',', 'thank', 'you', '.'] load bert model over证明可以正常使用。 |

【本文地址】

今日新闻 |

推荐新闻 |